26 のビッグ データ分析テクニックの洞察:パート 2

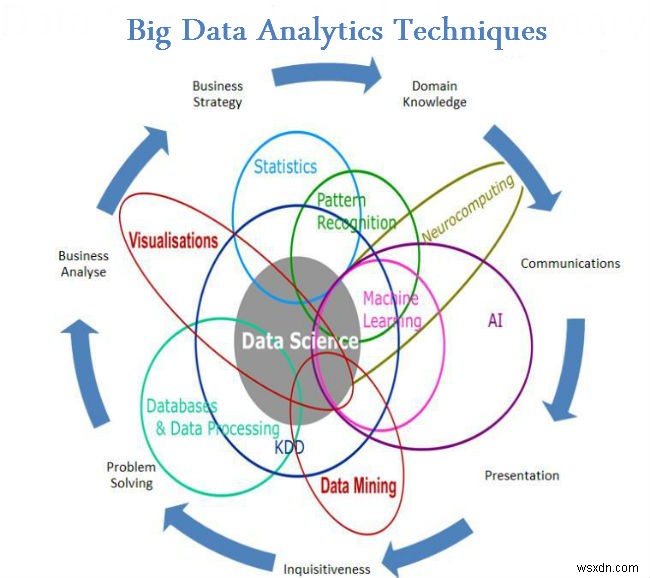

これまで、ビッグ データに関するブログで、ビッグ データの実際の意味から事実、すべきこと、すべきでないことまで、ビッグ データのさまざまな側面について説明してきました。前回のブログでは、いくつかのビッグ データ分析手法を見てきました。このブログでリストをさらに進めます。

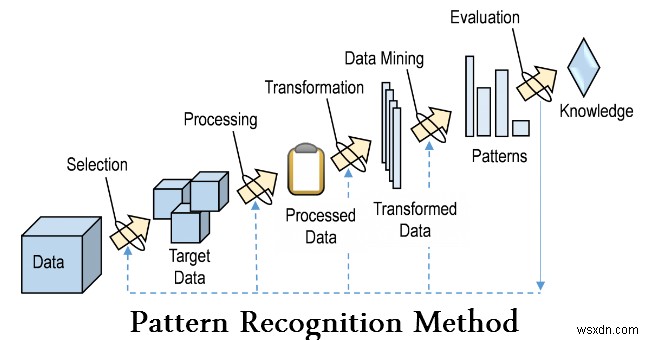

- パターン認識

パターン認識は機械学習の一分野であり、データのパターンと規則性の認識に焦点を当てていますが、場合によっては機械学習とほぼ同義であると考えられています。多くの場合、パターン認識システムは、ラベル付けされた「トレーニング」データ (教師あり学習) からトレーニングされますが、ラベル付けされたデータが利用できない場合は、他のアルゴリズムを使用して、以前は未知のパターンを発見できます (教師なし学習)。

- 予測モデリング

予測分析は、過去および現在のデータに基づいて将来の結果を予測するさまざまな手法で構成されています。実際には、予測分析は、数千のセンサーからのデータ ストリームに基づいてジェット エンジンの故障を予測することから、購入するもの、購入する時期、さらには何を購入するかに基づいて顧客の次の動きを予測することまで、ほぼすべての分野に適用できます。彼らはソーシャルメディアで言います。予測分析技術は、主に統計的手法に基づいています。

- 回帰分析

これは、独立変数を使用し、それらが従属変数に与える影響を利用する手法です。これは、インターネット プラットフォームで恋人を見つける確率など、ソーシャル メディア分析を決定する際に非常に役立つ手法です。

- 感情分析

感情分析は、研究者がトピックに関するスピーカーまたはライターの感情を判断するのに役立ちます。感情分析は次の目的で使用されています:

- ゲストのコメントを分析してホテル チェーンのサービスを改善する

- インセンティブとサービスをカスタマイズして、お客様が本当に求めているものに対応する

- ソーシャル メディアの意見に基づいて、消費者が実際にどう思っているかを判断する

- 信号処理

信号処理は、さまざまな物理的、記号的、または抽象的な形式に含まれる情報を処理または転送するための基本的な理論、アプリケーション、アルゴリズム、および実装を包含する実現技術です。 シグナル .数学的、統計的、計算的、発見的、言語的な表現、形式主義、および表現、モデリング、分析、合成、発見、回復、センシング、取得、抽出、学習、セキュリティ、または科学捜査のための手法を使用します。サンプル アプリケーションには、時系列分析のモデリングや、精度の低い一連のデータ ソースからのデータを組み合わせてより正確な読み取り値を決定するためのデータ フュージョンの実装 (つまり、ノイズからの信号の抽出) が含まれます。

- 空間分析

空間分析は、生データを有用な情報に変換するプロセスです。 It is the process of examining the locations, attributes, and relationships of features in spatial data through overlay and other analytical techniques in order to address a question or gain useful knowledge. Spatial analysis extracts or creates new information from spatial data.

- Statistics

In statistics, exploratory data analysis is an approach to analyzing data sets to summarize their main characteristics, often with visual methods. A statistical model can be used or not, but primarily EDA is for seeing what the data can tell us beyond the formal modelling or hypothesis testing task. Statistical techniques are also used to reduce the likelihood of Type I errors (“false positives”) and Type II errors (“false negatives”). An example of an application is A/B testing to determine what types of marketing material will most increase revenue.

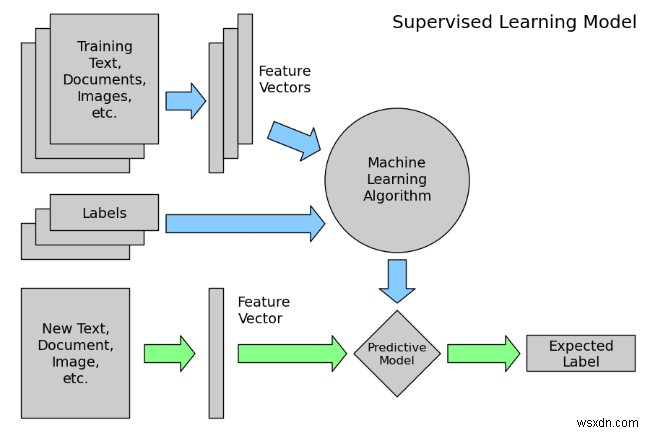

- Supervised learning

Supervised learning is the machine learning task of inferring a function from labeled training data. The training data consist of a set of training examples . In supervised learning, each example is a pair consisting of an input object (typically a vector) and a desired output value (also called the supervisory signal )。 A supervised learning algorithm analyzes the training data and produces an inferred function, which can be used for mapping new examples.

- Social Network Analysis

Social network analysis is a technique that was first used in the telecommunications industry, and then quickly adopted by sociologists to study interpersonal relationships. It is now being applied to analyze the relationships between people in many fields and commercial activities. Nodes represent individuals within a network, while ties represent the relationships between the individuals.

- Simulation

Modeling the behavior of complex systems, often used for forecasting, predicting and scenario planning. Monte Carlo simulations, for example, are a class of algorithms that rely on repeated random sampling, i.e., running thousands of simulations, each based on different assumptions. The result is a histogram that gives a probability distribution of outcomes. One application is assessing the likelihood of meeting financial targets given uncertainties about the success of various initiatives

- Time Series Analysis

Time series analysis comprises methods for analyzing time series data in order to extract meaningful statistics and other characteristics of the data. Time series data often arise when monitoring industrial processes or tracking corporate business metrics. Time series analysis accounts for the fact that data points taken over time may have an internal structure (such as autocorrelation, trend or seasonal variation) that should be accounted for. Examples of time series analysis include the hourly value of a stock market index or the number of patients diagnosed with a given condition every day.

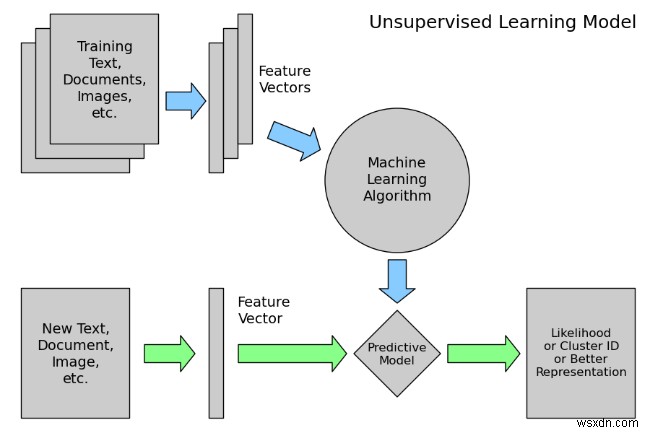

- Unsupervised Learning

Unsupervised learning is the machine learning task of inferring a function to describe hidden structure from unlabeled data. Since the examples given to the learner are unlabeled, there is no error or reward signal to evaluate a potential solution – this distinguishes unsupervised learning from supervised learning and reinforcement learning.

However, unsupervised learning also encompasses many other techniques that seek to summarize and explain key features of the data.

- Visualization

Data visualization is the preparation of data in a pictorial or graphical format. It enables decision makers to see analytics presented visually, so they can grasp difficult concepts or identify new patterns. With interactive visualization, you can take the concept a step further by using technology to drill down into charts and graphs for more detail, interactively changing what data you see and how it’s processed.

Conclusion

Big data analytics has been one of the most important breakthroughs in the information technology industry. In fact, Big Data has shown its importance and need almost in all sectors, and in all the departments of those industries. There is not a single aspect of life which has not been affected by Big Data, not even our personal lives. Hence we need Big Data Analytics to manage this huge amounts of Data efficiently.

As said before this list is not exhaustive. Researchers are still experimenting on new ways of Analyzing this huge amounts of Data which is present in a variety of forms whose speed of generation is increasing with time to derive values for our specific uses.

-

克服すべきビッグデータの課題

ビッグデータとは 機械の能力は限られています。パフォーマンスの制限の 1 つは、処理できるデータのサイズです。今日のマシンは大規模なデータを処理できますが、データ サイズの指数関数的な増加は依然として大きな問題です。 今日の日付のデータは巨大で、指数関数的に増加しています。このサイズの増加により、データを保存および処理する従来の方法はうまく機能しません。 この問題を克服するには、この膨大な量のデータを処理できるシステムまたはプロセスが必要です。ビッグ データは、高度なリアルタイム処理ユニットと、巨大なデータを簡単に処理できるすぐに利用できるハードウェアを使用するプロセスです。 デー

-

2022 年ベスト 10 のビッグデータ分析ツール

ビッグ データ分析ツールは、データ セットへの洞察を提供します。データは、さまざまなビッグ データ クラスターから収集されます。このツールは、企業がデータの傾向を理解し、パターンとその複雑さを作成し、データをわかりやすいデータ視覚化に変換するのに役立ちます。 ビッグデータは雑然としているため、ビジネスのパフォーマンスを理解し、顧客の洞察を得るには、分析ツールが非常に重要です。オンラインで利用できるデータ分析ツールは多数あるため、この記事は洞察を得て、最適なビッグデータ分析ツールを選択するのに役立ちます。 2022 年ビッグデータ分析ツール トップ 10 大小を問わず、あらゆるビジネスに最適